Zone de lecture principale avec sommaire latéral.

Définition précise de la latence de monitoring et son impact sur les systèmes

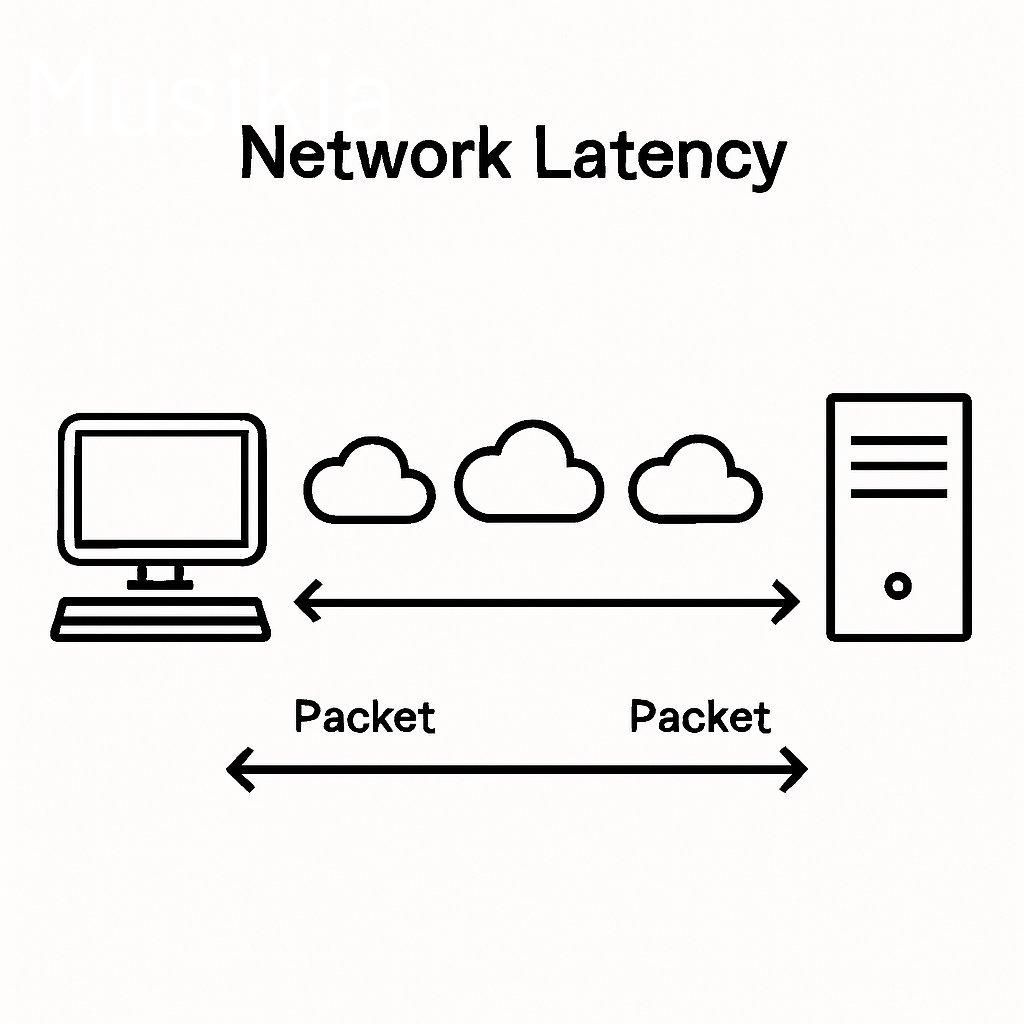

La latence de monitoring se définit comme le délai entre la détection d’un incident par les agents de supervision et la réaction corrective mise en œuvre pour résoudre ce problème. Ce laps de temps influence directement la continuité et la qualité des services offerts. En parallèle, elle correspond au temps nécessaire pour qu’un paquet de données soit transmis d’un point à un autre dans un réseau, impactant ainsi la fluidité des communications et l’expérience utilisateur.

Dans les environnements critiques, une latence élevée peut provoquer des interruptions, des pertes de données et une perte de fiabilité globale du système. Pour cette raison, une supervision proactive est essentielle afin d’assurer la disponibilité et la résilience des infrastructures. Par ailleurs, dans les architectures de stockage décentralisé, la latence représente le temps de transit d’un paquet entre des nœuds indépendants. Cela affecte directement les performances et les temps de réponse dans ces environnements distribués.

Facteurs déterminants influençant la latence dans les systèmes et réseaux

Plusieurs éléments jouent un rôle fondamental dans la latence observée au sein des systèmes et réseaux. La configuration réseau et l’infrastructure matérielle, notamment la distance géographique entre les points d’échange, la qualité du matériel utilisé et les interférences, constituent des facteurs cruciaux qui conditionnent la latence totale.

Impact des protocoles de communication et de consensus

Les protocoles employés, qu’ils soient de communication ou de consensus comme PBFT ou Raft, ont une influence directe sur la latence, surtout dans les réseaux distribués où la cohérence des données est primordiale. Ces protocoles régulent les échanges et la validation, ce qui affecte le délai total de traitement.

Configurations actives-actives versus actives-passives

Les architectures actives-actives assurent une synchronisation continue entre nœuds, réduisant ainsi fortement la latence, au prix d’une consommation de ressources plus élevée. A contrario, les configurations actives-passives, plus économiques, introduisent des temps de basculement plus longs, car le système de secours reste inactif jusqu’à activation.

Autres facteurs influençant la latence

La congestion réseau, la bande passante disponible et la gestion efficace du cache jouent aussi un rôle décisif. Une congestion ou une bande passante insuffisante peuvent entraîner des délais importants, tout comme une mauvaise gestion du cache dans les systèmes qui en dépendent.

Mesure et indicateurs clés pour évaluer la latence de monitoring

Évaluer précisément la latence de monitoring exige l’utilisation de plusieurs indicateurs clés. Le temps de récupération, la perte de paquets, le débit ainsi que le temps de réponse sont essentiels pour apprécier la performance et la réactivité des systèmes supervisés.

Visualisation et détection via tableaux de bord

Les tableaux de bord en temps réel offrent une visualisation continue qui facilite la détection rapide des anomalies et des points de latence excessifs, permettant ainsi une prise de décision rapide.

Tests automatisés pour fiabilité

Les tests automatisés de basculement simulent diverses situations pour garantir la cohérence des mesures, renforçant la fiabilité du suivi de la latence sur le long terme.

Surveillance continue et analyse dynamique

Associer une supervision 24/7 à une analyse fine des variations de latence permet d’assurer une gestion optimale de la réactivité face aux incidents et d’anticiper les problèmes avant qu’ils ne perturbent le service.

Techniques et solutions pratiques pour réduire la latence en monitoring

Pour maîtriser efficacement la latence, plusieurs leviers techniques et organisationnels sont à actionner.

- Choisir un prestataire MSP expérimenté en supervisant une définition claire des SLA, ce qui encadre précisément les temps de réponse et la qualité d’intervention.

- Utiliser des technologies basse latence telles que RDMA (Remote Direct Memory Access) qui optimisent les transferts en réduisant considérablement les délais de communication réseau.

- Automatiser les tâches de supervision pour éliminer les délais liés aux interventions humaines et accélérer la détection et la correction des incidents.

- Favoriser une intégration étroite entre les outils de monitoring et l’infrastructure IT pour garantir une communication fluide et des actions synchronisées.

- Déployer des protocoles de routage avancés ainsi que des méthodes comme le caching distribué, le sharding et la réplication optimisée pour les environnements distribués.

- Exploiter l’edge computing afin de rapprocher le traitement et la surveillance des points de collecte de données, réduisant ainsi la latence induite par la distance géographique.

Gestion opérationnelle et surveillance continue pour maîtriser la latence

Une gestion rigoureuse et continue de la latence repose sur plusieurs bonnes pratiques opérationnelles. Une surveillance permanente, 24h/24 et 7j/7, accompagnée de tableaux de bord en temps réel, facilite la détection immédiate des anomalies susceptibles d’impacter la latence.

Combiner automatisation des traitements et supervision humaine assure une capacité d’adaptation rapide aux variations de performance – une exigence dans les environnements critiques. En outre, la réalisation régulière de tests de basculement validés garantit la cohérence des mesures et permet d’ajuster les procédures en fonction des différents scénarios d’incident.

Ajuster en permanence les seuils des SLO est indispensable pour adapter la tolérance à la latence en fonction des conditions réelles, alignant ainsi la performance et le respect des SLA convenus. Tout cela s’appuie sur une infrastructure robuste et des outils de monitoring adaptés qui ensemble favorisent la résilience et maintiennent une expérience utilisateur optimale.

Commentaires